Retour sur la journée d'écoconception numérique 2026

le 17 février 2026, par - 14 min de lecture

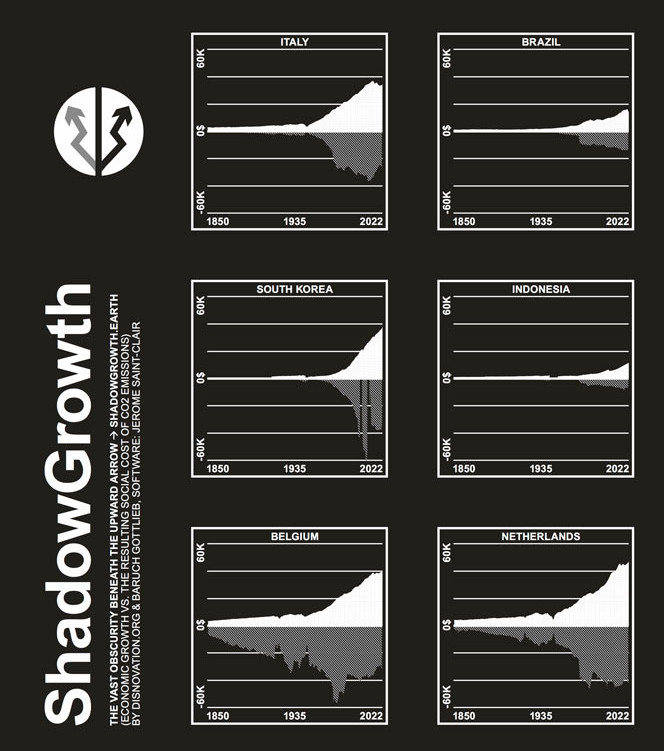

Shadow Growth de disnovation.org et le jeux Trois Rivières

Shadow Growth de disnovation.org et le jeux Trois Rivières

Actualité oblige, la journée de l’écoconception numérique des designers éthiques avait beaucoup tourné autour de l’IA en 2025, démystifiant ses mécanismes et effets délétères notamment sur l’environnement. Cette année, il était encore question de la technologie dont tout le monde parle mais en prenant de la hauteur, comme l’annonçait la keynote “ancrer le numérique dans le réel”. Retour sur cette édition riche et variée.

Après une introduction rappelant la philosophie de l’événement (engagé, frugal, accessible, transparent, autour du partage) et la présence des stands, dont celui de l’association Point de M.I.R présentant le jeu Écon[u]m, entrons dans le vif du sujet : la réalité du numérique.

Ancrer le numérique dans le réel

C’est Mathilde Saliou qui officie pour cette keynote. Journaliste chez Next, autrice du livre “L’envers de la tech” et du podcast “Entre la chaise et le clavier”, elle nous explique qu’après le problème des bateaux à quai qui continuaient de brûler du fioul lourd, ce sont à présent les nombreux datacenters qui ont poussé dans la cité phocéenne qui réprésentent une nouvelle source de cohabitation difficile avec les marseillais·es. Elle va revenir sur les mythes du numérique, leurs soubassements idéologiques et les axes pour réagir.

Les images qui véhiculent ces mythes sont celles de la dématérialisation et de la super-intelligence. Ses promesses sont :

- les connexions (collectif)

- la dématérialisation (sans frontières)

- l’efficacité, la performance

- le progrès (bénéfice universel)

En même temps nous observons de multiples contre-exemples pour chacune de ces promesses :

- Les interruptions de service de AWS et les équipements domotiques (chaudières, lits chauffants, serrures) qui dysfonctionnent ;

- La suppression du “double numérique” de Nicolas Guillou (juge de la CPI) après la fermeture de son compte Microsoft ;

- La politique erratique du DOGE et d’Elon Musk avec la suppression de l’agence USAid ayant des conséquences désastreuses sur l’Afrique entre autres ;

- Le recul de la vaccination aux États-Unis, pays de la technologie ;

- Les exploitation minière du cobalt en RDC et du lithium au Chili entraînant des pollutions de longue durée et des conditions de travail nous ramenant aux mines du XIXe siècle ;

- Une idéologie impérialiste dans l’accaparement globalisé des cultures pour alimenter les modèles d’IA, des minerais pour la fabrication des objets technologiques (voir les travaux d’Ophélie Coelho) ;

- Les villes libertariennes et féodales (comme la ville de Prospera au Honduras) et les déplacements des populations locales, par exemple pour la “Trump Riviera” en Palestine.

Finalement cet impérialisme nous ramène dans les conditions des années 30 avec un recul des droits de l’homme et de la démocratie dans les pays occidentaux. Elle rappelle les 14 signes pour reconnaître le fascisme de Umberto Eco.

Trois écologies pour résister

- Écologie environnementale : faire durer nos équipements ;

- Écologie des rapports humains : construire des technologies qui répondent aux besoins humains. Établir une “politique du renoncement”, comme dirait Alexandre Monnin ;

- Écologie de la technologie : moins de numérique, moins de dépendances numériques (géopolitique, politique…).

Elle fait l’éloge de la lenteur (la technologie apporte une illusion de vitesse), propose de rechercher la friction avec les outils numériques, d’interroger le besoin et appelle à une autonomie individuelle et collective, par le logiciel libre et la coopération, de l’échelle européenne à celle d’une ville ou d’un village.

Atelier sur la Sobriété Editoriale

Férréole Lespinasse et Luz Delgado Bautista (Sujet d’inclusion & consultant en design stratégique) nous guident pendant cet atelier sur la sobriété éditoriale. Le public est composé pour beaucoup de personnes travaillant dans le champ de l’expérience utilisateur, ou la gestion de produits web.

Ferréole nous donne d’abord quelques statistiques sur les contenus en ligne :

- 96% des pages web n’ont aucun trafic

- 54% des français souffrent de fatigue informationnelle

- 80% de créateurs de contenus sont en épuisement professionnel

- 60% des contenus sont jugés “ennuyeux”

Par ailleurs, 45% du public arrête de suivre des marques qui publient trop quand 18% du public arrête de suivre des marques qui publient peu. Il y a donc plus de chances de perdre des utilisateurs ou clients en publiant trop de contenus. On observe également un pareto : 20% du contenu génère l’essentiel du trafic d’un site web.

Le paysage des technologies de l’information est saturé… en information. L’objectif de la sobriété éditoriale est d’apporter un regard critique et constructif à tous les niveaux de la création de contenus. Il s’agit de communiquer moins et de communiquer mieux. Cela questionne la stratégie, les contenus et leur cycle de vie.

Pourquoi faire ? Pour le respect des lecteurs, pour la planète, pour la prospérité (meilleure diffusion des contenus). C’est une forme d’écoconception qui suit la règle des 3U : les textes doivent être Utiles, Utilisables et Utilisés.

La méthode est constituée de 6 étapes :

- Quand faut -il communiquer ?

- Avant de créer le contenu, interroger son utilité

- Avant de créer le contenu, déterminer son format

- En créant le contenu, veiller à sa qualité.

- Piloter le cycle de vie du contenu

- Améliorer en continu

Les premiers pas peuvent être constitués par l’archivage des contenus obsolètes, la suppression des posts anciens des réseaux sociaux. Sur la page ressources de son site vous trouverez plein d’outils dont les deux principaux : les 48 Bonnes pratiques et le référentiel de conformité.

Le droit fait il avancer l’adoption de l’écoconception ?

Photo de Sasun Bughdaryan sur Unsplash

Lise Breteau (avocate dans le domaine du numérique responsable) nous propose de nous intéresser à la manière de répondre aux impacts directs de l’écoconception (environnementaux et sociaux) et indirects c’est à dire liés aux modèles économiques sous-jacents (croissance court-terme, reculs réglementaires, extractivisme). Pourquoi ne pas élargir la démarche vers une éco-socio-conception ?

Positionnement et portée

Il est préférable d’envisager l’écoconception au plus tôt, dans la phase amont de la “chaîne de conformité”. Autrement dit, le “by design”. Du point de vue juridique cela apporte des éléments de preuve. Quel intérêt à prouver l’exécution d’une obligation légale ou contractuelle ?

- Montrer la priorisation du sujet : même si des erreurs sont faites plus tard, cela prouve sa bonne foi ;

- Fournir une analyse poussée dès le départ du projet ;

- Mettre en oeuvre des moyens adéquats.

Quelle portée l’éconception a-t-elle pour agir sur les impacts du numérique ? Les services numériques ne sont que la face visible de l’iceberg du numérique. Dans la partie immergée on retrouve le matériel (clients, serveurs), les centres de données, les processus de fabrication de ces équipements, les aspects socio-économiques, géopolitiques etc. Il s’agit de faire sa part.

Il existe deux types de loi : la soft law ou non-réglementaire comme le RGESN, le label NR, ou encore le référentiel de Sobriété Editoriale ci-dessus. Et la hard law qui oblige les entreprises répondant à certains critères (nombre de salariés, activité, chiffre d’affaire, etc.), à respecter des règlements européens ou nationaux. On peut citer pour l’Europe le Digital Markets Act (DMA), le Digital Services Act (DSA), ou le RGPD ; pour la France, la loi REEN, le RGAA (liste non exaustive).

Comment les acteurs de l’écoconception peuvent-ils se saisir de ces outils pour défendre un numérique plus durable ?

Le consentement selon le RGPD est LE texte qui intègre le mieux l’écoconception dans le champ réglementaire. C’est un texte fort :

- art. 5 : limitation et minimisation des traitements

- art. 7 : demande de consentement

- art. 12 : oblication de communiquer de façon concise, précise, transparente…

En ce qui concerne l’IA et l’économie de l’attention :

“ce sont des notions chapeau qui recouvrent de multiples services et modèles économiques”

Les textes de l’écoconception reconnus pour encadrer l’IA sont le RGESN (soft law) et la loi REEN (hard law). En 2024, l’Europe a adopté le RIA (le Règlement Européen pour l’IA), quel rôle envisager pour l’avenir pour ce texte ? Il fonctionne essentiellement sur des outils de soft law.

L’écoconception peut contribuer à encadrer l’économie de l’attention. En soft law il y a le RGESN, et en hard law, le DSA et RGPD. Le code de la consommation peut aussi jouer un rôle pour les pratiques commerciales déloyales ou aggressives. Selon son analyse, la soft law est insuffisante pour contrer les pratiques de très grandes plateformes. La hard law nécessite de mettre en cause des responsabilités sur le terrain du contentieux et procédural.

Enfin, les Communs Numériques avec les licences libres fournissent une offre diversifiée et mature pour tous les types de communs numériques (logiciels, base de données, écrits). Son analyse montre néanmoins qu’il existe une complexité qui aboutit à des applications maladroites (voire inopérantes sur le plan juridique) des licences libres. Par exemple utiliser une licence de type logicielle (ex GPL) pour des contenus (préférer Creative Commons). De plus les atteintes sont peu sanctionnées.

Elle conclut en soulignant les besoins : de promouvoir le libre dans les usages numériques ainsi que de monter en compétence sur le logiciel libre dans toutes les organisations. Pour cela, il serait précieux d’avoir des professionnels du libre qui viennent éclairer le législateur, ainsi que de valoriser le rôle des syndicats comme le courrier du premier ministre aux partenaires sociaux du 29 septembre 2025 l’encourage.

Enjeux environnementaux de l’IA : état des lieux et pistes de recommandations

Nous retrouvons une thématique qui nous est chère, avec Tom Nico de l’Arcep. Il vient présenter les travaux pré-réglementaires sur l’IA pour l’Europe. L’essor rapide de l’intelligence artificielle générative s’accompagne d’une prise de conscience accrue de l’impact environnemental du numérique dans un contexte marqué par la loi REEN2 et les réflexions sur un numérique plus soutenable.

Le rapport “IA générative : des défis pour l’avenir de l’Internet” sorti en janvier donne un premier aperçu de cette problématique.

La croissance de l’IA générative est impressionnante, tant en nombre d’utilisateurs (700M d’utilisateurs pour OpenAI) que de modèles déployés. Cette dynamique exerce une pression croissante sur les centres de données, dont l’empreinte environnementale progresse sur les trois principaux indicateurs : émissions de gaz à effet de serre, consommation d’électricité et consommation d’eau. Entre 2022 et 2023, cette dernière a augmenté de près de 19 %. S’y ajoutent des enjeux d’artificialisation des sols et, à moyen terme, des interrogations sur la capacité des réseaux à absorber cette montée en charge (voir l’étude Carbon leakage in AI-driven data center growth?).

Ce sujet est au coeur de nombreuses recherches académiques et le rapport Sopra Steria (2024) sur l’IA et l’environnement en donne un bon résumé.

Les impacts de l’IA restent toutefois difficiles à quantifier précisément, en raison d’un manque de transparence des acteurs principaux sur les deux phases d’utilisation de l’IA : lors de l’entraînement (voir l’étude Hubblo 2025 More than Carbon: Cradle-to-Grave environmental impacts of GenAI training on the Nvidia A100 GPU) et de l’inférence des grands modèles (voir Luccionni et al 2023 Power Hungry Processing: Watts Driving the Cost of AI Deployment?) . Mais la part exacte de l’IA générative demeure mal identifiée. Une approche par l’analyse de cycle de vie apparaît indispensable pour mieux évaluer ces impacts, depuis la fabrication des composants jusqu’aux usages des services.

Si les modèles gagnent en efficacité énergétique, ces progrès peuvent être compensés par un effet rebond lié à la multiplication des usages. L’impact environnemental global de l’IA générative reste donc largement incertain.

Les proposition de l’Arcep sont les suivantes :

- Transparence environnementale : nécessité d’ACV multicritères. Il y a par exemple peu de données sur les puces électroniques. Il faudrait une évaluation systématique sur des formats standardisés et un mandat légal de collecte de données ;

- Responsabiliser les grands fournisseurs de services IA : code de conduite (CoC), soft law (RGESN) notamment sur le volet algorithmique. Étudier le(s) lien(s) entre IA et économie de l’attention ;

- Encourager l’utilisation de modèles plus sobres. Adapter les modèles aux besoins des utilisateurs permet d’obtenir jusqu’à 90% d’économie d’énergie ;

- Tenir compte des enjeux environnementaux dans les différents outils de politiques publiques : encourager le recours à l’IA frugale. Formations à ces enjeux. Enjeu d’éco-conditionalité : par exemple, obligation de mesurer la consommation énergétique. Coopération internationale pour une harmonisation de ces outils.

Zapping découverte ou la tech-underground

Richard Hanna nous présente son nouveau jeu sorti il y a une dizaine de jours : Trois-Rivières. Réalisé en javascript en opensource avec comme seule dépendance le moteur phaser, il peut tourner sur des très petites configurations (par exemple des mobiles âgés de 8 ans). Dès 11 ans, promenez-vous dans le village des Trois Rivières, avec des villageois plein d’ironie, pour enquêter sur la source de pollution des rivières.

Adrien Payet nous montre son site web extensible permettant de contrer le mythe numérique = dématérialisé. Ou une autre idée de matière : un site anguleux et sans animation qui met au coeur de la démarche l’origine et le plus petit élément de nos écrans : le pixel. C’est un travail de la matière au sens artistique du terme. Réalisé à partir d’un générateur de site statique, il montre qu’une variation subtile peut avoir des effets importants (doublement de la taille de la page avec une nouvelle fonte).

Remise des prix de la bourse de l’écoconception

-

“Go libre girls”, 7 membres d’“une collective” non mixte. Tourné vers le web et reconsidération plus libriste du design graphique. Elles ont fait un jeu low tech, avec des figures big tech qui vont pouvoir être déboulonnées.

-

“Le droit à la déconnexion” : Léo Sacha s’est intéressé à l’automatisation de la connexion/déconnexion au réseau Internet sur mobile. Ou comment rendre la connexion volontaire plutôt que activée “par défaut”.

-

Strata : Arthur Goujon Master design à Toulouse. Il est proche de la sphère permacomputing. Il a travaillé sur une coque d’ordinateur portable, réutilisable et opensource pour durer le plus longtemps possible. Il parle de longévité programmée.

Disnovation.org

Collectif oeuvrant autour de la post-croissance en mêlant art et technologie, réflexions et expériences. Retrouvez tous leurs projets sur leur site. Pour donner quelques exemples :

- “Life Support System” : pour montrer ce que serait la valeur intrinsèque des services écosystémiques ils cultivent 1 m2 de blé élevé artificiellement : ~300€.

- “Shadow Growth” : coûts sociaux et environnementaux d’une tonne de carbone émise en partant d’un papier scientifique. La somme des coûts est mise en regard de la production par le PIB.

Pour tous ces projets ils se sont posé la question du format pour la diffusion de leurs vidéos. Ils en sont arrivés à concevoir un nouveau format : ZeroNet. L’idée est de faire des vidéos avec des effets locaux (kenburns, slides…) en HTML, CSS et Javascript. On passe de 5 à 50 MB/min à 2,5MB/min avec de la rasterisation et de l’audio compressé c’est à dire 96% de moins qu’une vidéo 4K.

Conclusion

Nous avons raté l’atelier de David Ekchajzer “Du meilleur au pire : Identifier et comprendre les effets indirects de solutions numériques” ainsi que la conférence de Mellie La Roque “Penser un service numérique dans les limites planétaires” ou encore l’atelier de Timothée Goguely “Les navigateurs web textuels : une alternative radicale face à la surcharge du web ?”. Nous pourrons retrouver certaines captures sur le site peertube des Designers Éthiques.

Le budget global de l’événement est de 60K environ. Pour moitié financé par la billetterie, un quart mécénat, un quart subvention publique. C’est difficile d’organiser un tel événement donc leur message : n’hésitez pas à nous soutenir.

Nous avons été étonnés (et la longueur de l’article l’illustre) par la richesse, la diversité des sujets ainsi que la qualité des intervenants. Vivement l’année prochaine !

Les bonnes pratiques de l'IA responsable

le 26 décembre 2025, par - 5 min de lecture

Qu’on parle ou non d’IA, lorsqu’on identifie un besoin dans une organisation, ou dans un contexte personnel, la première question à se poser est souvent la suivante : a-t-on besoin du numérique pour y répondre ? Et si oui, l’IA est-elle réellement nécessaire ? Ou bien une “simple” digitalisation sans IA est-elle suffisante ? Dans ce dernier volet de notre série sur l’IA, nous allons évoquer les bonnes pratiques de l’IA responsable.

Réglementation et souveraineté numérique

le 24 décembre 2025, par - 5 min de lecture

Photo de Guillaume Périgois sur Unsplash

Photo de Guillaume Périgois sur Unsplash

Les enjeux humains et éthiques de l'IA

le 17 décembre 2025, par - 8 min de lecture

Notre premier épisode résumait le cycle de vie de l’IA et les impacts environnementaux associés. Nous allons voir dans cet article les problèmes liés aux données d’entraînement et aux “travailleurs du clic” qui, tels des turcs mécaniques, rendent l’artificialité des matrices mathématiques intelligentesintelligibles. Nous évoquerons aussi les sujets de transparence et de confiance.

Le Cycle de vie de l'IA

le 11 décembre 2025, par - 7 min de lecture

Il y a quelques mois, nous avons réalisé en collaboration avec i-We et pour le compte du Groupe Caisse des Dépôts le contenu d’un module d’e-learning portant sur les usages éclairés de l’IA. Depuis, l’IA est restée très présente dans l’actualité et dans notre écosystème, beaucoup de personnes se questionnent : on nous demande souvent que penser de cette technologie et quoi en faire. Nous avons donc choisi de publier sur notre blog, avec l’aimable autorisation du Groupe CDC et d’i-We, les scripts réalisés pour ce e-learning, légèrement adaptés au format blog. Nous espérons que cette ressource profitera au plus grand nombre et que vous y trouverez des informations et des pistes de réflexion qui vous aideront à y voir plus clair sur l’IA - notamment générative - et sur les enjeux environnementaux et humains qui se cachent derrière. Nous entamons cette série de 4 articles par la présentation d’une synthèse du cycle de vie de l’IA.