Réglementation et souveraineté numérique

le 24 décembre 2025, par 5 min de lecture

Photo de Guillaume Périgois sur Unsplash

Photo de Guillaume Périgois sur Unsplash

Dans l’épisode précédent, nous avons abordé les impacts de l’essor de l’IA sur les petites mains qui alimentent les modèles d’IA, ainsi que les problèmes éthiques liés à l’IA, notamment générative. Dans cet article nous allons parler Règlement européen sur l’Intelligence Artificielle et souveraineté numérique.

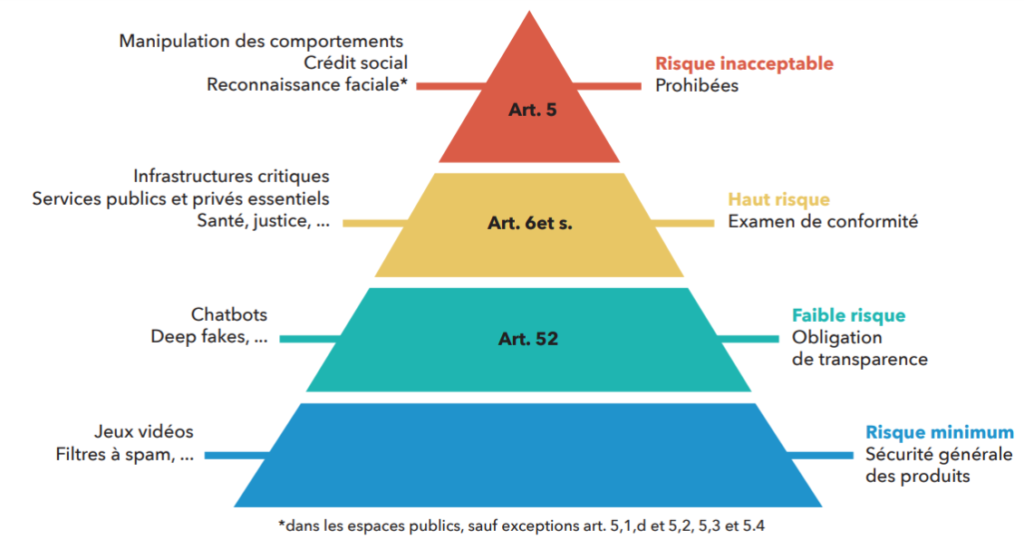

Face aux enjeux liés aux usages de l’IA, le RIA - aussi appelé AI Act - qui entre en vigueur progressivement, constitue un cadre réglementaire permettant le développement et le déploiement d’IA respectueuses des valeurs européennes. Ce règlement classifie les modèles et les systèmes d’IA en utilisant une approche par les risques : une série de critères permet de déterminer le niveau de risque dont relève le modèle ou le système considéré, et ainsi de déterminer les obligations auxquelles les organisations doivent se conformer, étant donné leur rôle vis-à-vis du modèle ou système en question.

Le RIA distingue 4 niveaux de risque pour les systèmes d’IA automatisés :

- les systèmes présentant un risque minime ou inexistant pour leurs utilisateurs : un filtre anti-spam par exemple. Ces systèmes ne font l’objet d’aucune restriction au titre du RIA, dès lors qu’ils respectent les autres réglementations.

- les systèmes interagissant avec des personnes physiques mais ne présentant pas de risque élevé, et pour lesquels il importe principalement à l’utilisateur de savoir qu’il interagit avec une machine : un chatbot ou un générateur d’images par exemple. Les entités fournissant ou déployant ces systèmes doivent faire en sorte que les utilisateurs sachent clairement qu’ils interagissent avec une IA, ou que le contenu qu’ils consultent a été généré par une IA.

- les systèmes présentant un risque élevé, qui peuvent avoir un impact direct sur la sécurité ou les droits fondamentaux de personnes physiques : les systèmes de recrutement automatisé par IA ou de reconnaissance biométrique par exemple. Ces systèmes sont soumis à diverses obligations incluant par exemple la conservation de logs d’activité, la mise en place d’un contrôle humain, la mise en place d’un système de gestion de la qualité, etc.

- les systèmes présentant un risque inacceptable, c’est-à-dire portant atteinte aux droits fondamentaux ou contrevenant aux valeurs de l’Union Européenne : les systèmes de score social ou permettant la manipulation subliminale des opinions par exemple. Ces systèmes sont purement et simplement interdits.

Le RIA constitue une réglementation pionnière en matière d’encadrement des activités basées sur l’IA. On peut noter que les Etats-Unis et la Chine, principaux rivaux dans la course au développement de l’IA, prennent le parti de moins réguler l’IA, même si le cadre réglementaire progresse également dans ces deux pays. Le RIA établit également des sanctions à l’encontre des entreprises ne respectant pas ses obligations : une entreprise contrevenant par exemple à l’interdiction des systèmes d’IA présentant un risque inacceptable peut se voir infliger une amende allant jusqu’à 7% de son chiffre d’affaires.

IA et souveraineté numérique

Le paysage de l’IA souffre aujourd’hui d’une domination des acteurs étatsuniens et chinois : les géants de la tech tels que Google, Meta ou OpenAI ont imposé leurs modèles d’IA auprès du grand public et comptent de très nombreux utilisateurs ; la Chine mobilise de son côté de nombreuses ressources pour faire émerger ses propres géants nationaux, dont certains ont créé la surprise dans le monde occidental à l’image de DeepSeek. Les deux pays mènent une course effrénée à l’innovation en matière d’IA, mêlant enjeux technologiques, économiques et géopolitiques complexes.

A l’ère de l’IA générative, la prédominance de systèmes d’IA provenant des Etats-Unis ou de la Chine pose plusieurs problèmes. Un premier problème concerne nos données personnelles : nous confions effectivement parfois des données sensibles à des chatbots, pour leur demander de résumer des documents, de nous conseiller sur un cadeau à offrir voire de nous fournir un avis médical… Se pose alors la question des usages qui pourraient être faits de ces données par des tiers soumis à des réglementations extra-européennes qui n’en garantissent pas forcément la protection. Les Etats-Unis, typiquement, disposent d’une réglementation moins contraignante en matière de protection des données personnelles. Avec le règlement européen sur l’IA et le RGPD, les entreprises européennes doivent s’assurer que leurs technologies respectent les exigences en matière de transparence et de protection des données personnelles.

On peut également craindre l’émergence de monopoles qui peuvent s’établir pour l’utilisation de certains outils, et induire des rapports de force : il peut être risqué de dépendre exclusivement d’outils étrangers pour certaines tâches importantes. Dans ce cadre, disposer d’outils souverains, c’est-à-dire relevant de nos Etats et réglementations (France, Union Européenne), est un enjeu crucial. Enfin, l’enjeu des biais, dont nous avons parlé dans l’article précédent, joue également un rôle : un modèle entraîné sur une majorité de données en langue anglaise ou chinoise par exemple sera moins adapté, en matière de culture, de valeurs (idéologiques, politiques…) ou de vision du monde, à une utilisation en français.

Face à ces enjeux, des réponses européennes et françaises existent. Une première réponse est constituée par la réglementation (cf le RIA ci-dessus). Une deuxième réponse est bien entendu l’émergence d’acteurs souverains : par exemple, des entreprises françaises qui développent des modèles d’IA entraînés sur des données adaptées au contexte français ou européen et dans le respect des réglementations encadrant le traitement des données personnelles ou le droit d’auteur. Enfin, l’utilisation d’infrastructures souveraines - data centers français par exemple - permet de réduire notre dépendance aux acteurs étrangers et d’héberger modèles et données sur le sol européen.

Retrouvez les autres articles de notre série sur l’IA responsable :